机器之心收拾

参加:一鸣、杜伟

本周论文有:颜水成团队的「PSGAN 一键上妆」,黄亮团队在同传使命的集束查找进步行了一些改善,一起还有 NLP 相关总述、方针检测最新 SOTA 作用、数字在词嵌入中的处理研讨等。

目录:

A Survey of the Usages of Deep Learning in Natural Language Processing

CBNet: A Novel Composite Backbone Network Architecture for Object Detection

A Comparative Study on Transformer vs RNN in Speech Applications

Do NLP Models Know Numbers? Probing Numeracy in Embeddings

HYPE: A Benchmark for Human eYe Perceptual evaluation of Generative Models

PSGAN: Pose-Robust Spatial-Aware GAN for Customizable Makeup Transfer

Speculative Beam Search for Simultaneous Translation

论文 1:A Survey of the Usages of Deep Learning in Natural Language Processing

作者:

Daniel W. Otter、Julian R. Medina、Jugal K. Kalita

论文链接:

https://arxiv.org/pdf/1807.10854v2

摘要:曩昔数年,深度学习模型的爆破式运用推动了天然言语处理范畴的开展。在本文中,研讨者扼要介绍了天然言语处理范畴的基本状况,并概述了深度学习架构和办法。然后,他们对近来的研讨进行了挑选,对许多相关的文献打开总结。除了许多计算机言语学的运用之外,研讨者还剖析研讨了言语处理方面的几个核心问题。终究他们评论了当时 SOTA 技能和办法并对该范畴未来的研讨提出了主张。

论文中总结的 Transformer 架构。a)有四个编码器和四个解码器的 Transformer 块;b)编码器的架构,包含一个自留意力层(黄色)和一个前馈网络(绿色);c)解码器架构,包含自留意力层(黄色)、留意力编码-解码层(紫色)和前馈网络(绿色)。

引荐:天然言语处理发展到哪一步了?本文全面总述了当时天然言语处理范畴的研讨发展,并探讨了不同 NLP 使命下的研讨状况、SOTA 技能,并评论了未来的研讨方向。

论文 2:CBNet: A Novel Composite Backbone Network Architecture for Object Detection

作者:Yudong Liu、Yongtao Wang、Siwei Wang、TingTing Liang、Qijie Zhao、Zhi Tang、Haibin Ling

论文链接:https://arxiv.org/pdf/1909.03625v1.pdf

摘要:在现有的 CNN 检测器中,骨干网络是特征提取的重要组件,检测器的功能很大程度上依赖于骨干网络。近来,来自北京大学王选计算机研讨所和纽约州立大学石溪分校的研讨者宣布了一篇论文:根据现有骨干网络(如 ResNet 和 ResNeXt)构建愈加强壮的新式骨干网络,然后完成更好的检测功能。详细而言,研讨者提出一种集成多个相同骨干网络的新战略,即经过附近骨干网络之间的组合衔接(composite connection)构建一个更强壮的骨干网络——Composite Backbone Network (CBNet)。CBNet 迭代地将前一个骨干网络的输出特征(即高档特征)输入到下一个骨干网络中,逐渐进行一向到终究一个骨干网络(Lead Backbone)的特征图,然后运用该特征图进行方针检测。研讨标明,CBNet 能够轻松整合到当时最优的检测器,并大幅提高功能。例如,它将 FPN、Mask R-CNN 和 Cascade R-CNN 在 COCO 数据集上的 mAP 提高了 1.5%-3.0%。一起,试验作用证明,CBNet 还能够提高实例切割作用:简略地将 CBNet 集成到基线检测器 Cascade Mask R-CNN,即可完成单个模型在 COCO 数据集上的新 SOTA 作用(mAP 到达 53.3),这标明 CBNet 架构十分有用。

CBNet 架构图示。

引荐:方针检测现已是一个十分老练的范畴了,而能够在这一使命上改写 SOTA 作用十分不易。这篇来自北大和纽约大学石溪分校的论文阐明,整合多个骨干网络便能改写最佳作用。

论文 3:AComparative Study on Transformer vs RNN in Speech Applications

作者:Shigeki Karita、Nanxin Chen、Tomoki Hayashi、Takaaki Hori、Hirofumi Inaguma 等

论文链接:https://arxiv.org/pdf/1909.06317v1.pdf

摘要:Seq2seq 模型已广泛运用于主动语音辨认(ASR)、语音转化(ST)以及文字转语音(TTS)等端到端语音处理中。本文侧重叙述序列到序列模型 Transformer,它在神经机器翻译(NMT)和其他天然语音处理运用中完成了当时 SOTA 功能。研讨者深入研讨并在 15 个 ASR、1 个多言语 ASR、1 个 ST 和 2 个 TTS 基准上剖析比较了 Transformer 和循环神经网络(RNN)。试验提醒了每项使命上运用 Transformer 取得的不同练习技巧和明显的功能优势,其间包含第 13 个 ASR 基准上 Transformer 所体现出来的巨大优越性。经过运用敞开资源和揭露可用的数据集,研讨者还预备推出 Kaldi 风格的可复现办法,以运用于一切的 ASR、ST 和 TTS 使命,使得社区能够连续他们的研讨作用。

引荐:语音辨认范畴一向在运用最新的 Seq2seq 模型,可是哪一种架构是最好的呢?本文对比了 Transformer 和 RNN 两大在语音辨认范畴的运用广泛的架构,并得出了终究的定论。本文合适入门语音辨认范畴的读者了解序列模型的运用。

论文 4:Do NLP Models Know Numbers? Probing Numeracy in Embeddings

作者:Eric Wallace、Yizhong Wang、Sujian Li、Sameer Singh、Matt Gardner

论文链接:https://arxiv.org/pdf/1909.07940.pdf

摘要:了解和处理数字(识数)的才干关于许多杂乱的推理使命来说至关重要。现在,大多数天然言语处理模型处理文本中数字的办法与其他 token 相同,将这些数字作为分布式向量嵌入。这种处理办法足以捕捉数字吗?在本文中,研讨者首要研讨了 DROP 数据集上 SOTA 问答模型的数字推理才干,发现该模型拿手处理需求数字推理的问题,也就是说它现已能够捕捉数字。为了解这种才干是怎样获取的,研讨者在归纳列表最大值(synthetic list maximum)、数字解码和 jiafa 使命上对 token 嵌入办法(如 BERT、GloVe 等)进行测验。例如,GloVe 和 word2vec 能够精确编码多达 1000 个数字。字符级嵌入乃至愈加精确,其间在一切预练习办法中,ELMo 的数字捕捉才干最强壮,而运用字词单元的 BERT 模型精确性不如 ELMo。

研讨者练习了一个 probing model,根据词嵌入对 [-500, 500] 区间内随机 80% 的整数进行数字解码,如「71」 71.0。

引荐:一向不知道词嵌入是怎样处理数字的?这篇论文运用因果推理使命复原了数字字符在词嵌入模型中的被处理的办法,阐明词嵌入关于数字的处理相同可行,不论是整数仍是浮点数。

论文 5:HYPE: A Benchmark for Human eYe Perceptual evaluation of Generative Models

作者:Sharon Zhou、Mitchell L. Gordon、Ranjay Krishna、Austin Narcomey、Li Fei-Fei、Michael S. Bernstein

论文链接:https://arxiv.org/pdf/1904.01121.pdf

摘要:生成模型一般运用人工测评来衡量其输出作用的感知质量。主动衡量是伴有噪声的直接署理,由于这些衡量依托启发式或预练习嵌入。但直到现在,直接的人工测评战略都是针对特定范畴,既没有完成规范化,也没有经过验证。来自斯坦福大学的研讨者们为生成实时性(generative realism)构建了一个通用的人工测评基准,将其命名为人眼感知点评(human eye perception evaluation,HYPE),具有以下特征:(1)根据感知的心理物理学研讨,(2)对同一模型随机采样输出的不同调集均体现出可靠性,(3)能够别离模型功能,(4)节约本钱和时刻。此外,他们提出了两种变体:一种是在自适应时刻束缚下丈量视觉感知,以确认模型输入显现为实在时的阈值;另一种是本钱较低的变体,其能够在无时刻束缚的状况下丈量真假图画上的人为误差率。经过运用 CelebA、FFHQ、CIFAR-10 和 ImageNet 四个数据集,研讨者们环绕有条件和无条件图画生成范畴的 6 种当时 SOTA 生成对立网络和 2 种采样办法对 HYPE 进行测验,发现 HYPE 能够追寻模型之间的相对改善,并经过自助采样法(bootstrp sampling)确认这些丈量作用是一致和可复现的。

引荐:来自斯坦福大学研讨者的这项作用为人眼点评生成模型作用提出了量化规范,合适相关研讨者参阅这一点评系统。

论文 6:PSGAN: Pose-Robust Spatial-Aware GAN for Customizable Makeup Transfer

作者:Wentao Jiang、Si Liu、Chen Gao、Jie Cao、Ran He、Jiashi Feng、Shuicheng Yan

论文链接:https://arxiv.org/pdf/1909.06956.pdf

摘要:在搬迁学习范畴,有一个使命名为妆容搬迁(makeup transfer),行将恣意参照图画上的妆容搬迁到不带妆容的源图画上。许多人像美化运用都需求这种技能。近来的一些妆容搬迁办法大都根据生成对立网络(GAN)。它们一般选用 CycleGAN 的结构,并在两个数据集进步行练习,即无妆容图画和有妆容图画。可是,现有的办法存在一个局限性:只在正面人脸图画上体现杰出,没有为处理源图画和参照图画之间的姿势和表情差异专门规划模块。别的,它们也不能在测验阶段直接用于部分妆容搬迁,由于它们无法以可感知空间的办法提取妆容特征。为了战胜这些问题以更好地服务实在国际场景,颜水成团队提出了一种全新的姿势稳健型可感知空间式生成对立网络(PSGAN)。这种 PSGAN 首要分为三部分:妆容提炼网络(MDNet)、留意式妆容变形(AMM)模块和卸装-再化装网络(DRNet)。研讨者以为,这三种新提出的模块能让 PSGAN 具有上述的完美妆容搬迁模型所应具有的才干。

PSGAN 的作用。该模型可让用户操控所要搬迁的浓浅程度和图画区域。榜首行左边是仅搬迁参照图画的部分妆容风格的作用,第二行左边则是不同浓浅程度的作用。此外,PSGAN 也能应对图画之间不同的姿势和表情,如图右侧所示。

如图展现了 PSGAN 的结构,其可分为三部分:妆容提炼网络(MDNet)、留意式妆容变形(AMM)模块、卸装-再化装网络(DRNet)。

引荐:颜水成团队的这篇论文是 GAN 的一种最新的运用,为咱们供给了一种搬迁化装的办法。或许今后再也不需求试试才知道化装作用了,AI 一键生成,作用拔群。

论文 7:Speculative Beam Search for Simultaneous Translation

作者:Renjie Zheng、Mingbo Ma、Baigong Zheng、Liang Huang

论文地址:https://arxiv.org/pdf/1909.05421v1.pdf

摘要:集束查找是全句翻译使命中广泛运用的技能,可是同声传译范畴仍然有许多问题。这是由于输出的词总是需求等候句子完毕才干确认。特别是最近提出的「wait-k」办法是一个简略而有用的处理办法,在开始等候后,在得到一个输入词的状况下确认一个输出词,可是这样会使得集束查找变得不可行。为了处理这一问题,研讨者提出了一种名为「猜想式集束查找」的算法,能够隐式地从方针言语模型中提早猜想后几步的作用,用于取得更精确的作用。

引荐:本文作者为百度的黄亮等,在同声传译方面取得了新的发展。

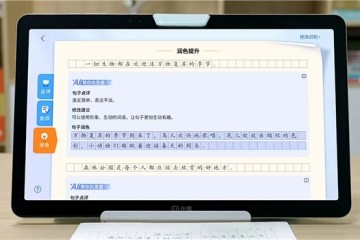

电视淡出年轻人生活圈,闺蜜机引领新潮流

电视淡出年轻人生活圈,闺蜜机引领新潮流 深入探索“AI+教育”,大模型提速智慧教育创新升级

深入探索“AI+教育”,大模型提速智慧教育创新升级 全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” 体育摄影如何放心拍摄与存储 使用NAS+专业硬盘轻松归档与备份

体育摄影如何放心拍摄与存储 使用NAS+专业硬盘轻松归档与备份 铁威马新品上市,高性能NAS助力日常生活更便捷

铁威马新品上市,高性能NAS助力日常生活更便捷 铁威马F4-424 Pro:跃升存储之巅,专业NAS的极致体验

铁威马F4-424 Pro:跃升存储之巅,专业NAS的极致体验 铁威马发布全新NAS,配置强悍,引领潮流!

铁威马发布全新NAS,配置强悍,引领潮流! 铁威马NAS新品F4-424 Pro上线:打工人的年货好礼

铁威马NAS新品F4-424 Pro上线:打工人的年货好礼